본 시리즈는 가시다님의 AEWS(AWS EKS Workshop) 1기 진행 내용입니다. (가시다님 노션)

스터디에 사용되는 링크 (AWS EKS Workshop)

목차

1. AWS Controller for Kubernetes (ACK)

2. Flux

EKS 클러스터 세팅 (Cloudformation)

https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/eks-oneclick6.yaml

1. AWS Controller for Kubernetes (ACK)

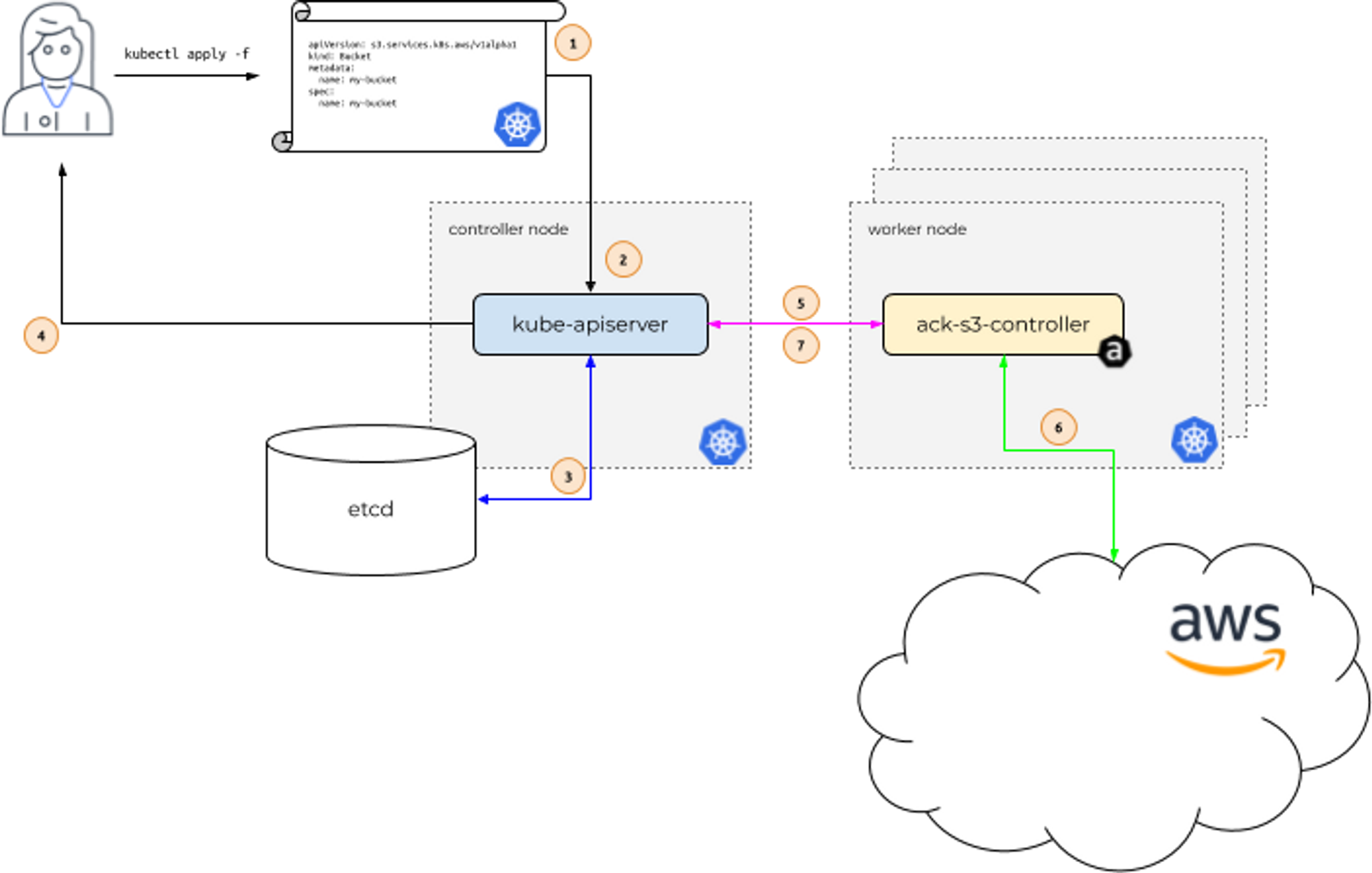

ACK

- aws 서비스 리소스를 k8s 에서 직접 정의하고 사용 할 수 있음

- 예시) 사용자는 kubectl (쿠버네티스 api) 를 사용하여 AWS S3 버킷을 생성 할 수 있다

- 예시) 쿠버네티스 api 는 ack-s3-controller 에 요청을 전달하고, ack-s3-controller(IRSA)이 AWS S3 API 를 통해 버킷을 생성하게 됩니다

ACK 가 지원하는 AWS 서비스

- (‘23.5.29일) 현재 17개 서비스는 GA General Availability (정식 출시) 되었고, 10개는 Preview (평가판) 상태입니다 - 링크

- Maintenance Phases 관리 단계 : PREVIEW (테스트 단계, 상용 서비스 비권장) , GENERAL AVAILABILITY (상용 서비스 권장), DEPRECATED, NOT SUPPORTED

- GA 서비스 : ApiGatewayV2, CloudTrail, DynamoDB, EC2, ECR, EKS, IAM, KMS, Lambda, MemoryDB, RDS, S3, SageMaker…

- Preview 서비스 : ACM, ElastiCache, EventBridge, MQ, Route 53, SNS, SQS…

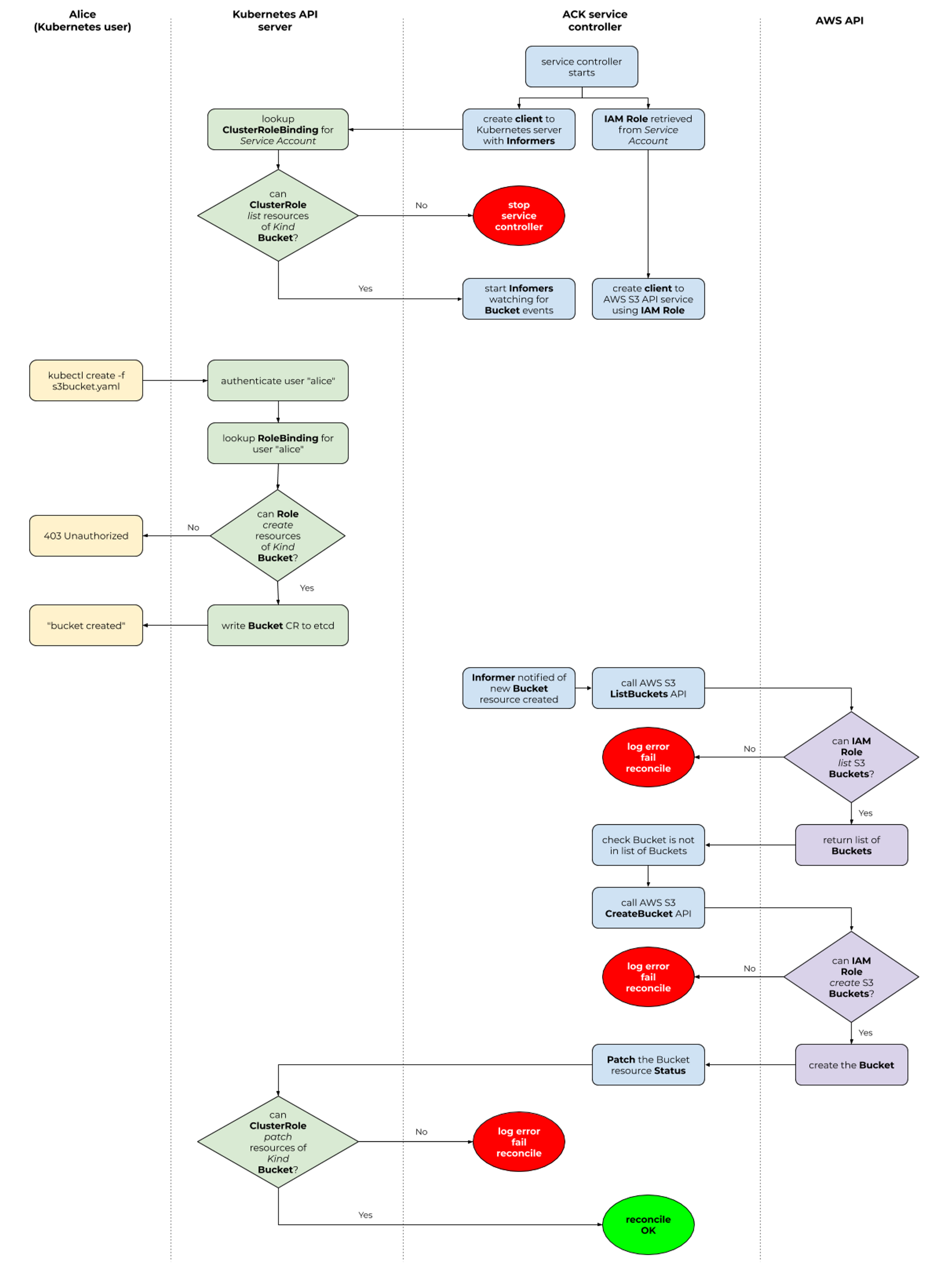

Permissions

- k8s api 와 aws api 의 2개의 RBAC 시스템 확인, 각 서비스 컨트롤러 파드는 AWS 서비스 권한 필요 ← IRSA role for ACK Service Controller

서비스 별 ACK Controller 설치(w/Helm) 과 IAM Permissions 설정은 서비스 이름만 변수(예. SERVICE=s3 혹은 SERVICE=rds) 에 지정해서 CMD 복사/붙여넣기 하자

S3

ACK S3 Controller 설치 with Helm - 링크 Public-Repo Github

# 서비스명 변수 지정

export SERVICE=s3

# helm 차트 다운로드

#aws ecr-public get-login-password --region us-east-1 | helm registry login --username AWS --password-stdin public.ecr.aws

export RELEASE_VERSION=$(curl -sL https://api.github.com/repos/aws-controllers-k8s/$SERVICE-controller/releases/latest | grep '"tag_name":' | cut -d'"' -f4 | cut -c 2-)

helm pull oci://public.ecr.aws/aws-controllers-k8s/$SERVICE-chart --version=$RELEASE_VERSION

tar xzvf $SERVICE-chart-$RELEASE_VERSION.tgz

# helm chart 확인

tree ~/$SERVICE-chart

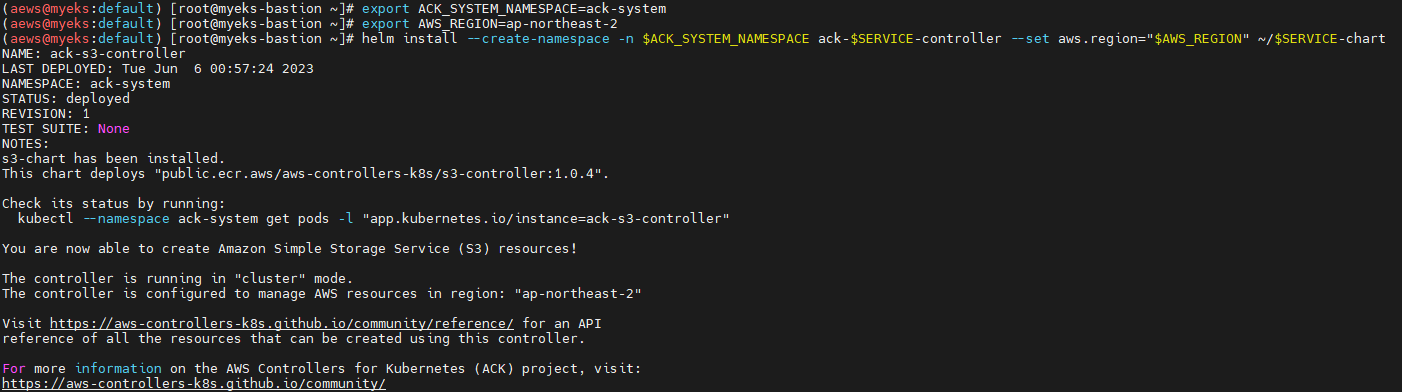

# ACK S3 Controller 설치

export ACK_SYSTEM_NAMESPACE=ack-system

export AWS_REGION=ap-northeast-2

helm install --create-namespace -n $ACK_SYSTEM_NAMESPACE ack-$SERVICE-controller --set aws.region="$AWS_REGION" ~/$SERVICE-chart

# 설치 확인

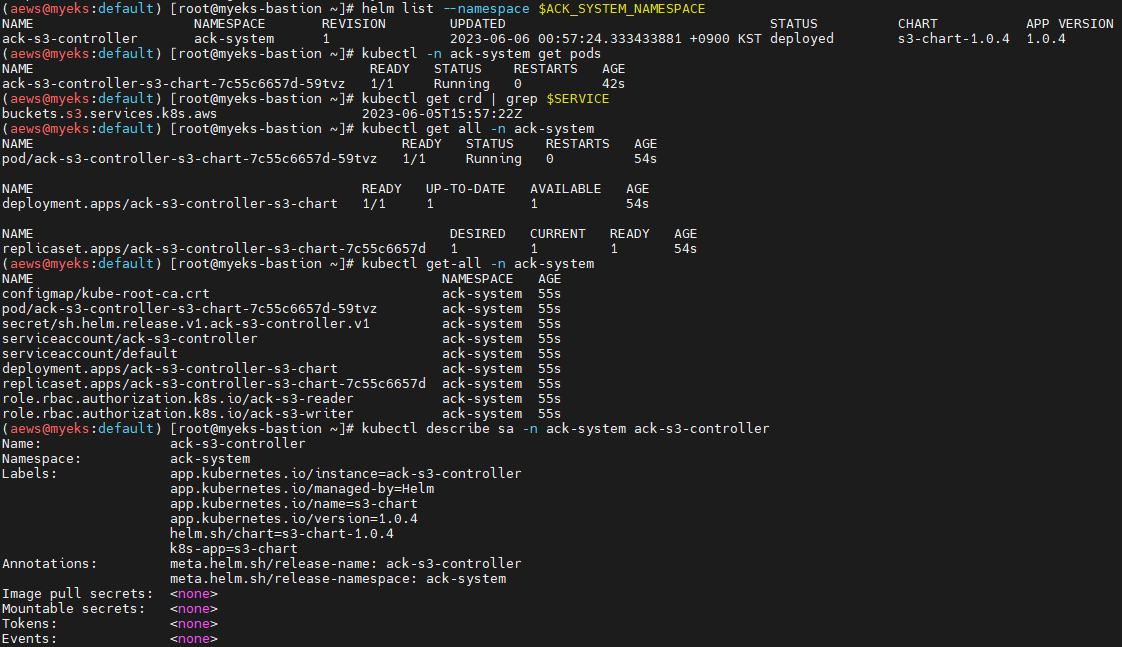

helm list --namespace $ACK_SYSTEM_NAMESPACE

kubectl -n ack-system get pods

kubectl get crd | grep $SERVICE

buckets.s3.services.k8s.aws 2022-04-24T13:24:00Z

kubectl get all -n ack-system

kubectl get-all -n ack-system

kubectl describe sa -n ack-system ack-s3-controller

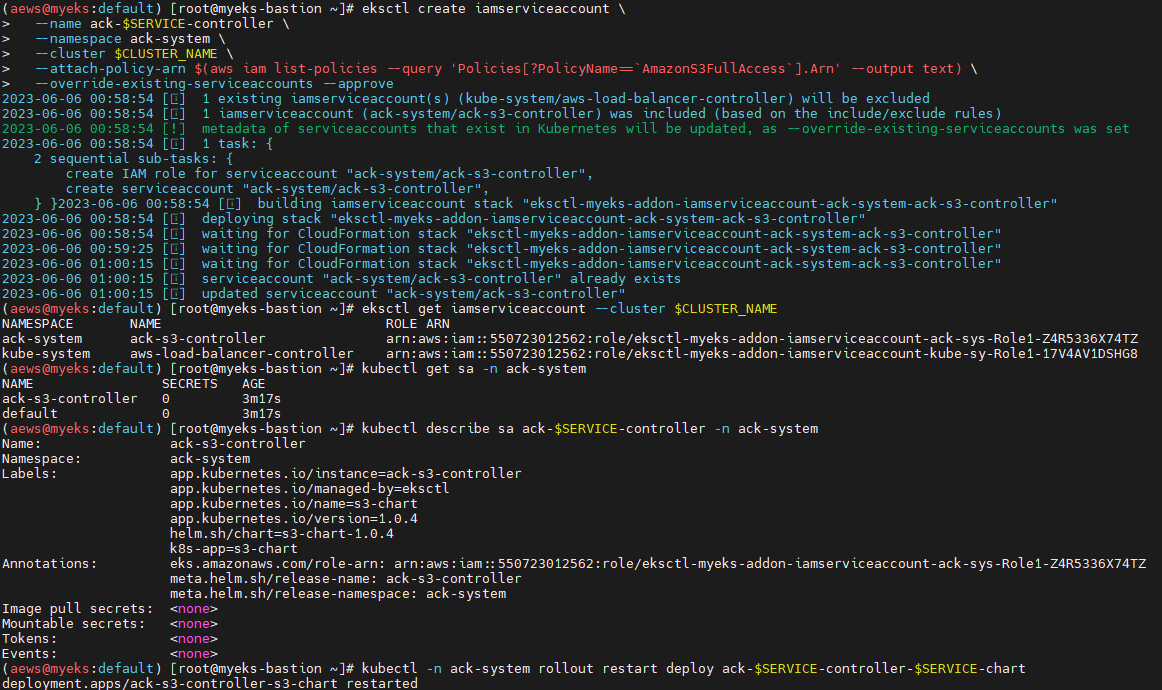

IRSA 설정 : 권장 정책 AmazonS3FullAccess - 링크

# Create an iamserviceaccount - AWS IAM role bound to a Kubernetes service account

eksctl create iamserviceaccount \

--name ack-$SERVICE-controller \

--namespace ack-system \

--cluster $CLUSTER_NAME \

--attach-policy-arn $(aws iam list-policies --query 'Policies[?PolicyName==`AmazonS3FullAccess`].Arn' --output text) \

--override-existing-serviceaccounts --approve

# 확인 >> 웹 관리 콘솔에서 CloudFormation Stack >> IAM Role 확인

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

# Inspecting the newly created Kubernetes Service Account, we can see the role we want it to assume in our pod.

kubectl get sa -n ack-system

kubectl describe sa ack-$SERVICE-controller -n ack-system

# Restart ACK service controller deployment using the following commands.

kubectl -n ack-system rollout restart deploy ack-$SERVICE-controller-$SERVICE-chart

# IRSA 적용으로 Env, Volume 추가 확인

kubectl describe pod -n ack-system -l k8s-app=$SERVICE-chart

...

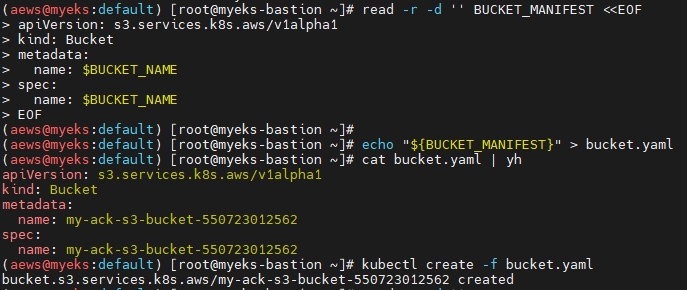

S3 버킷 생성, 업데이트, 삭제

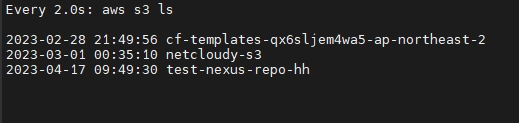

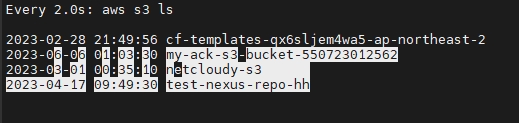

# [터미널1] 모니터링

watch -d aws s3 ls

# S3 버킷 생성을 위한 설정 파일 생성

export AWS_ACCOUNT_ID=$(aws sts get-caller-identity --query "Account" --output text)

export BUCKET_NAME=my-ack-s3-bucket-$AWS_ACCOUNT_ID

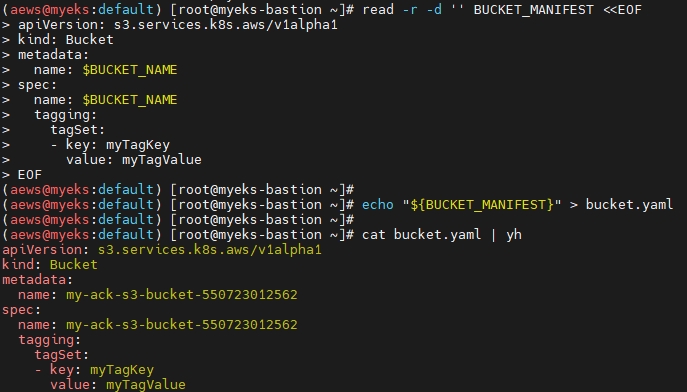

read -r -d '' BUCKET_MANIFEST <<EOF

apiVersion: s3.services.k8s.aws/v1alpha1

kind: Bucket

metadata:

name: $BUCKET_NAME

spec:

name: $BUCKET_NAME

EOF

echo "${BUCKET_MANIFEST}" > bucket.yaml

cat bucket.yaml | yh

# S3 버킷 생성

aws s3 ls

kubectl create -f bucket.yaml

bucket.s3.services.k8s.aws/my-ack-s3-bucket-<my account id> created

# S3 버킷 확인

aws s3 ls

kubectl get buckets

kubectl describe bucket/$BUCKET_NAME | head -6

Name: my-ack-s3-bucket-<my account id>

Namespace: default

Labels: <none>

Annotations: <none>

API Version: s3.services.k8s.aws/v1alpha1

Kind: Bucket

aws s3 ls | grep $BUCKET_NAME

2022-04-24 18:02:07 my-ack-s3-bucket-<my account id>

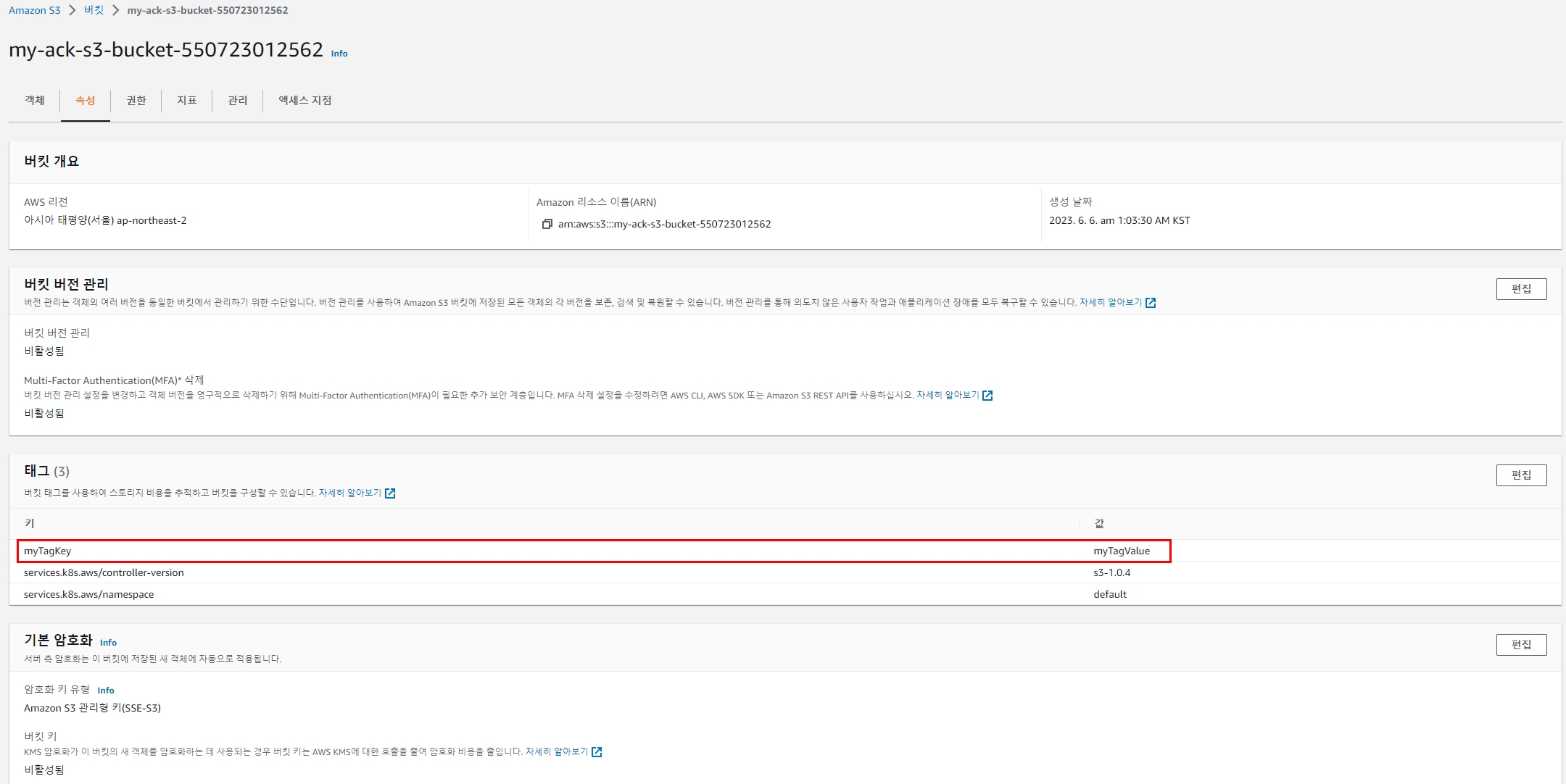

# S3 버킷 업데이트 : 태그 정보 입력

read -r -d '' BUCKET_MANIFEST <<EOF

apiVersion: s3.services.k8s.aws/v1alpha1

kind: Bucket

metadata:

name: $BUCKET_NAME

spec:

name: $BUCKET_NAME

tagging:

tagSet:

- key: myTagKey

value: myTagValue

EOF

echo "${BUCKET_MANIFEST}" > bucket.yaml

# S3 버킷 설정 업데이트 실행 : 필요 주석 자동 업뎃 내용이니 무시해도됨!

kubectl apply -f bucket.yaml

# S3 버킷 업데이트 확인

kubectl describe bucket/$BUCKET_NAME | grep Spec: -A5

Spec:

Name: my-ack-s3-bucket-<my account id>

Tagging:

Tag Set:

Key: myTagKey

Value: myTagValue

# S3 버킷 삭제

kubectl delete -f bucket.yaml

# verify the bucket no longer exists

kubectl get bucket/$BUCKET_NAME

aws s3 ls | grep $BUCKET_NAME

kubectl apply -f bucket.yaml 로 버킷 생성 후

ACK S3 Controller 삭제 - 링크

# helm uninstall

export SERVICE=s3

helm uninstall -n $ACK_SYSTEM_NAMESPACE ack-$SERVICE-controller

# ACK S3 Controller 관련 crd 삭제

kubectl delete -f ~/$SERVICE-chart/crds

# IRSA 삭제

eksctl delete iamserviceaccount --cluster myeks --name ack-$SERVICE-controller --namespace ack-system

# namespace 삭제 >> ACK 모든 실습 후 삭제

kubectl delete namespace $ACK_K8S_NAMESPACE

EC2 & VPC

ACK EC2-Controller 설치 with Helm - 링크 Public-Repo Github

# 서비스명 변수 지정 및 helm 차트 다운로드

export SERVICE=ec2

export RELEASE_VERSION=$(curl -sL https://api.github.com/repos/aws-controllers-k8s/$SERVICE-controller/releases/latest | grep '"tag_name":' | cut -d'"' -f4 | cut -c 2-)

helm pull oci://public.ecr.aws/aws-controllers-k8s/$SERVICE-chart --version=$RELEASE_VERSION

tar xzvf $SERVICE-chart-$RELEASE_VERSION.tgz

# helm chart 확인

tree ~/$SERVICE-chart

# ACK EC2-Controller 설치

export ACK_SYSTEM_NAMESPACE=ack-system

export AWS_REGION=ap-northeast-2

helm install -n $ACK_SYSTEM_NAMESPACE ack-$SERVICE-controller --set aws.region="$AWS_REGION" ~/$SERVICE-chart

# 설치 확인

helm list --namespace $ACK_SYSTEM_NAMESPACE

kubectl -n $ACK_SYSTEM_NAMESPACE get pods -l "app.kubernetes.io/instance=ack-$SERVICE-controller"

kubectl get crd | grep $SERVICE

dhcpoptions.ec2.services.k8s.aws 2023-05-30T12:45:13Z

elasticipaddresses.ec2.services.k8s.aws 2023-05-30T12:45:13Z

instances.ec2.services.k8s.aws 2023-05-30T12:45:13Z

internetgateways.ec2.services.k8s.aws 2023-05-30T12:45:13Z

natgateways.ec2.services.k8s.aws 2023-05-30T12:45:13Z

routetables.ec2.services.k8s.aws 2023-05-30T12:45:13Z

securitygroups.ec2.services.k8s.aws 2023-05-30T12:45:13Z

subnets.ec2.services.k8s.aws 2023-05-30T12:45:13Z

transitgateways.ec2.services.k8s.aws 2023-05-30T12:45:13Z

vpcendpoints.ec2.services.k8s.aws 2023-05-30T12:45:13Z

vpcs.ec2.services.k8s.aws 2023-05-30T12:45:13Z

IRSA 설정 : 권장 정책 AmazonEC2FullAccess - ARN

# Create an iamserviceaccount - AWS IAM role bound to a Kubernetes service account

eksctl create iamserviceaccount \

--name ack-$SERVICE-controller \

--namespace $ACK_SYSTEM_NAMESPACE \

--cluster $CLUSTER_NAME \

--attach-policy-arn $(aws iam list-policies --query 'Policies[?PolicyName==`AmazonEC2FullAccess`].Arn' --output text) \

--override-existing-serviceaccounts --approve

# 확인 >> 웹 관리 콘솔에서 CloudFormation Stack >> IAM Role 확인

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

# Inspecting the newly created Kubernetes Service Account, we can see the role we want it to assume in our pod.

kubectl get sa -n $ACK_SYSTEM_NAMESPACE

kubectl describe sa ack-$SERVICE-controller -n $ACK_SYSTEM_NAMESPACE

# Restart ACK service controller deployment using the following commands.

kubectl -n $ACK_SYSTEM_NAMESPACE rollout restart deploy ack-$SERVICE-controller-$SERVICE-chart

# IRSA 적용으로 Env, Volume 추가 확인

kubectl describe pod -n $ACK_SYSTEM_NAMESPACE -l k8s-app=$SERVICE-chart

...

VPC, Subnet 생성 및 삭제 - 링크

# [터미널1] 모니터링

while true; do aws ec2 describe-vpcs --query 'Vpcs[*].{VPCId:VpcId, CidrBlock:CidrBlock}' --output text; echo "-----"; sleep 1; done

# VPC 생성

cat <<EOF > vpc.yaml

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: VPC

metadata:

name: vpc-tutorial-test

spec:

cidrBlocks:

- 10.0.0.0/16

enableDNSSupport: true

enableDNSHostnames: true

EOF

kubectl apply -f vpc.yaml

vpc.ec2.services.k8s.aws/vpc-tutorial-test created

# VPC 생성 확인

kubectl get vpcs

kubectl describe vpcs

aws ec2 describe-vpcs --query 'Vpcs[*].{VPCId:VpcId, CidrBlock:CidrBlock}' --output text

# [터미널1] 모니터링

VPCID=$(kubectl get vpcs vpc-tutorial-test -o jsonpath={.status.vpcID})

while true; do aws ec2 describe-subnets --filters "Name=vpc-id,Values=$VPCID" --query 'Subnets[*].{SubnetId:SubnetId, CidrBlock:CidrBlock}' --output text; echo "-----"; sleep 1 ; done

# 서브넷 생성

VPCID=$(kubectl get vpcs vpc-tutorial-test -o jsonpath={.status.vpcID})

cat <<EOF > subnet.yaml

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: Subnet

metadata:

name: subnet-tutorial-test

spec:

cidrBlock: 10.0.0.0/20

vpcID: $VPCID

EOF

kubectl apply -f subnet.yaml

# 서브넷 생성 확인

kubectl get subnets

kubectl describe subnets

aws ec2 describe-subnets --filters "Name=vpc-id,Values=$VPCID" --query 'Subnets[*].{SubnetId:SubnetId, CidrBlock:CidrBlock}' --output text

# 리소스 삭제

kubectl delete -f subnet.yaml && kubectl delete -f vpc.yaml

vpc 생성 후 모니터링

subnet 생성 후 모니터링

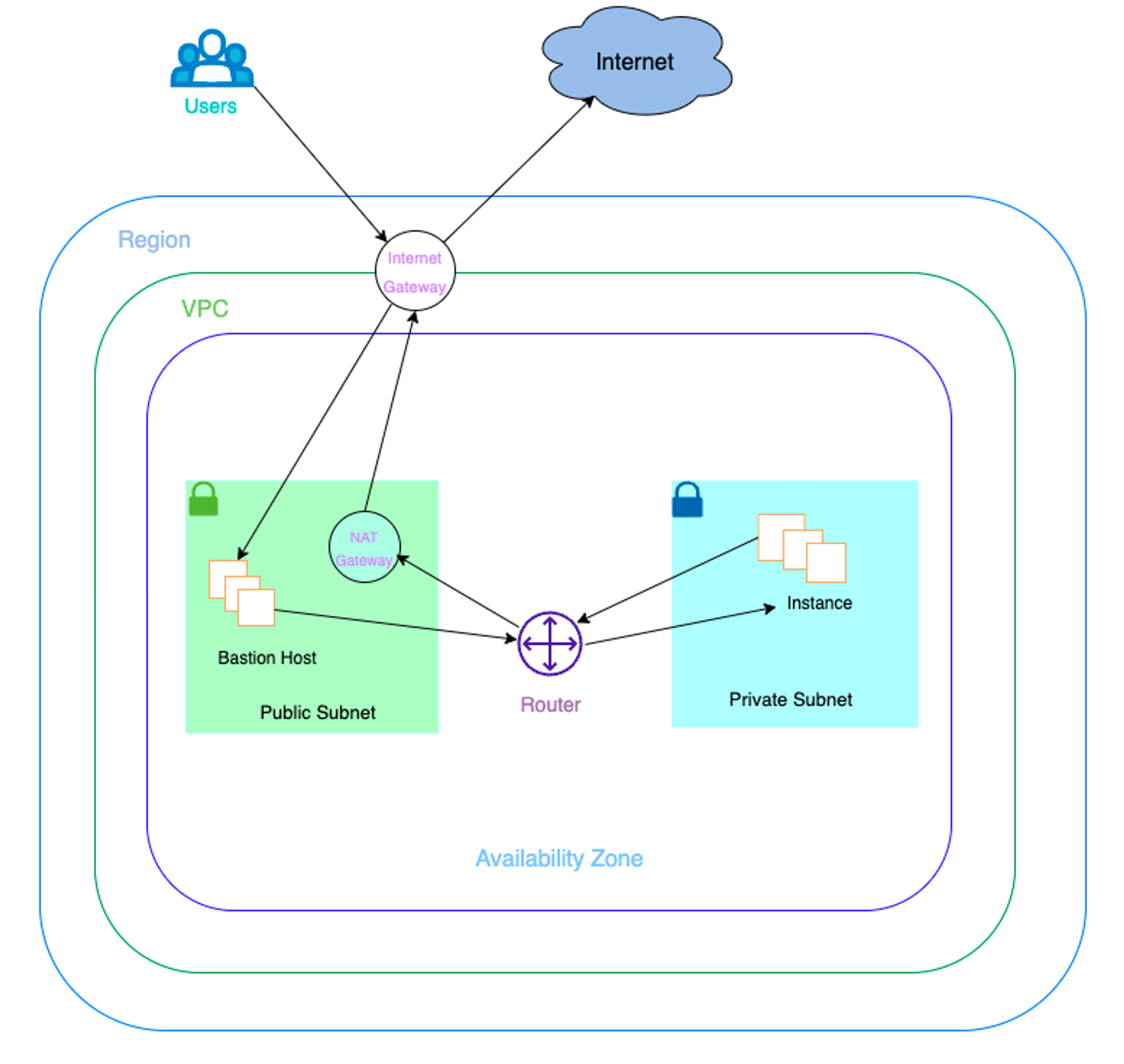

Create a VPC Workflow : VPC, Subnet, SG, RT, EIP, IGW, NATGW, Instance 생성 - 링크

cat <<EOF > vpc-workflow.yaml

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: VPC

metadata:

name: tutorial-vpc

spec:

cidrBlocks:

- 10.0.0.0/16

enableDNSSupport: true

enableDNSHostnames: true

tags:

- key: name

value: vpc-tutorial

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: InternetGateway

metadata:

name: tutorial-igw

spec:

vpcRef:

from:

name: tutorial-vpc

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: NATGateway

metadata:

name: tutorial-natgateway1

spec:

subnetRef:

from:

name: tutorial-public-subnet1

allocationRef:

from:

name: tutorial-eip1

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: ElasticIPAddress

metadata:

name: tutorial-eip1

spec:

tags:

- key: name

value: eip-tutorial

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: RouteTable

metadata:

name: tutorial-public-route-table

spec:

vpcRef:

from:

name: tutorial-vpc

routes:

- destinationCIDRBlock: 0.0.0.0/0

gatewayRef:

from:

name: tutorial-igw

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: RouteTable

metadata:

name: tutorial-private-route-table-az1

spec:

vpcRef:

from:

name: tutorial-vpc

routes:

- destinationCIDRBlock: 0.0.0.0/0

natGatewayRef:

from:

name: tutorial-natgateway1

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: Subnet

metadata:

name: tutorial-public-subnet1

spec:

availabilityZone: ap-northeast-2a

cidrBlock: 10.0.0.0/20

mapPublicIPOnLaunch: true

vpcRef:

from:

name: tutorial-vpc

routeTableRefs:

- from:

name: tutorial-public-route-table

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: Subnet

metadata:

name: tutorial-private-subnet1

spec:

availabilityZone: ap-northeast-2a

cidrBlock: 10.0.128.0/20

vpcRef:

from:

name: tutorial-vpc

routeTableRefs:

- from:

name: tutorial-private-route-table-az1

---

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: SecurityGroup

metadata:

name: tutorial-security-group

spec:

description: "ack security group"

name: tutorial-sg

vpcRef:

from:

name: tutorial-vpc

ingressRules:

- ipProtocol: tcp

fromPort: 22

toPort: 22

ipRanges:

- cidrIP: "0.0.0.0/0"

description: "ingress"

EOF# VPC 환경 생성

kubectl apply -f vpc-workflow.yaml

# [터미널1] NATGW 생성 완료 후 tutorial-private-route-table-az1 라우팅 테이블 ID가 확인되고 그후 tutorial-private-subnet1 서브넷ID가 확인됨 > 5분 정도 시간 소요

watch -d kubectl get routetables,subnet

# VPC 환경 생성 확인

kubectl describe vpcs

kubectl describe internetgateways

kubectl describe routetables

kubectl describe natgateways

kubectl describe elasticipaddresses

kubectl describe securitygroups

# 배포 도중 2개의 서브넷 상태 정보 비교 해보자

kubectl describe subnets

...

Status:

Conditions:

Last Transition Time: 2023-06-04T02:15:25Z

Message: Reference resolution failed

Reason: the referenced resource is not synced yet. resource:RouteTable, namespace:default, name:tutorial-private-route-table-az1

Status: Unknown

Type: ACK.ReferencesResolved

...

Status:

Ack Resource Metadata:

Arn: arn:aws:ec2:ap-northeast-2:911283464785:subnet/subnet-0f5ae09e5d680030a

Owner Account ID: 911283464785

Region: ap-northeast-2

Available IP Address Count: 4091

Conditions:

Last Transition Time: 2023-06-04T02:14:45Z

Status: True

Type: ACK.ReferencesResolved

Last Transition Time: 2023-06-04T02:14:45Z

Message: Resource synced successfully

Reason:

Status: True

Type: ACK.ResourceSynced

...

- 퍼블릭 서브넷에 인스턴스 생성

# public 서브넷 ID 확인

PUBSUB1=$(kubectl get subnets tutorial-public-subnet1 -o jsonpath={.status.subnetID})

echo $PUBSUB1

# 보안그룹 ID 확인

TSG=$(kubectl get securitygroups tutorial-security-group -o jsonpath={.status.id})

echo $TSG

# Amazon Linux 2 최신 AMI ID 확인

AL2AMI=$(aws ec2 describe-images --owners amazon --filters "Name=name,Values=amzn2-ami-hvm-2.0.*-x86_64-gp2" --query 'Images[0].ImageId' --output text)

echo $AL2AMI

# 각자 자신의 SSH 키페어 이름 변수 지정

MYKEYPAIR=<각자 자신의 SSH 키페어 이름>

MYKEYPAIR=kp-gasida

# 변수 확인 > 특히 서브넷 ID가 확인되었는지 꼭 확인하자!

echo $PUBSUB1 , $TSG , $AL2AMI , $MYKEYPAIR

# [터미널1] 모니터링

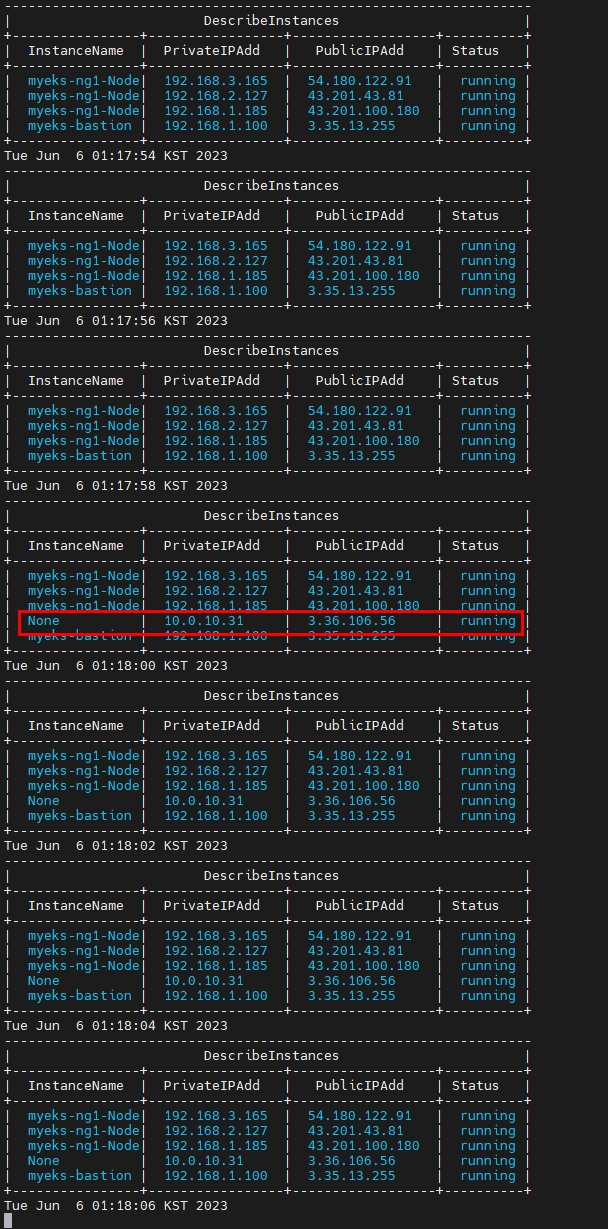

while true; do aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table; date ; sleep 1 ; done

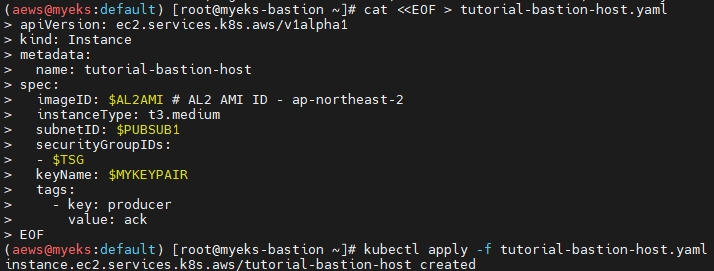

# public 서브넷에 인스턴스 생성

cat <<EOF > tutorial-bastion-host.yaml

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: Instance

metadata:

name: tutorial-bastion-host

spec:

imageID: $AL2AMI # AL2 AMI ID - ap-northeast-2

instanceType: t3.medium

subnetID: $PUBSUB1

securityGroupIDs:

- $TSG

keyName: $MYKEYPAIR

tags:

- key: producer

value: ack

EOF

kubectl apply -f tutorial-bastion-host.yaml

# 인스턴스 생성 확인

kubectl get instance

kubectl describe instance

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

이 서브넷에 Public EC2를 배포한 후

public 서브넷에 인스턴스 접속

ssh -i <자신의 키페어파일> ec2-user@<public 서브넷에 인스턴스 퍼블릭IP>

------

# public 서브넷에 인스턴스 접속 후 외부 인터넷 통신 여부 확인

ping -c 2 8.8.8.8

exit

------

보안 그룹 정책 수정 : egress 규칙 추가

cat <<EOF > modify-sg.yaml

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: SecurityGroup

metadata:

name: tutorial-security-group

spec:

description: "ack security group"

name: tutorial-sg

vpcRef:

from:

name: tutorial-vpc

ingressRules:

- ipProtocol: tcp

fromPort: 22

toPort: 22

ipRanges:

- cidrIP: "0.0.0.0/0"

description: "ingress"

egressRules:

- ipProtocol: '-1'

ipRanges:

- cidrIP: "0.0.0.0/0"

description: "egress"

EOF

kubectl apply -f modify-sg.yaml

# 변경 확인 >> 보안그룹에 아웃바운드 규칙 확인

kubectl logs -n $ACK_SYSTEM_NAMESPACE -l k8s-app=ec2-chart -f

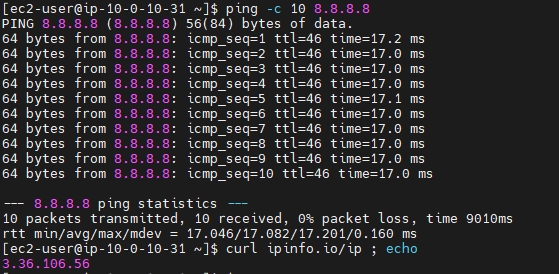

public 서브넷에 인스턴스 접속 후 외부 인터넷 통신 확인

ssh -i <자신의 키페어파일> ec2-user@<public 서브넷에 인스턴스 퍼블릭IP>

------

# public 서브넷에 인스턴스 접속 후 외부 인터넷 통신 여부 확인

ping -c 10 8.8.8.8

curl ipinfo.io/ip ; echo # 출력되는 공인IP는 무엇인가?

exit

------

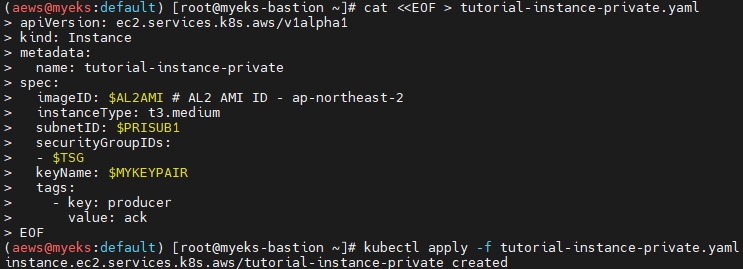

프라이빗 서브넷에 인스턴스 생성

# private 서브넷 ID 확인 >> NATGW 생성 완료 후 RT/SubnetID가 확인되어 다소 시간 필요함

PRISUB1=$(kubectl get subnets tutorial-private-subnet1 -o jsonpath={.status.subnetID})

echo $PRISUB1

# 변수 확인 > 특히 private 서브넷 ID가 확인되었는지 꼭 확인하자!

echo $PRISUB1 , $TSG , $AL2AMI , $MYKEYPAIR

# private 서브넷에 인스턴스 생성

cat <<EOF > tutorial-instance-private.yaml

apiVersion: ec2.services.k8s.aws/v1alpha1

kind: Instance

metadata:

name: tutorial-instance-private

spec:

imageID: $AL2AMI # AL2 AMI ID - ap-northeast-2

instanceType: t3.medium

subnetID: $PRISUB1

securityGroupIDs:

- $TSG

keyName: $MYKEYPAIR

tags:

- key: producer

value: ack

EOF

kubectl apply -f tutorial-instance-private.yaml

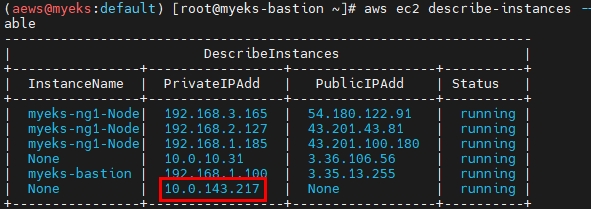

# 인스턴스 생성 확인

kubectl get instance

kubectl describe instance

aws ec2 describe-instances --query "Reservations[*].Instances[*].{PublicIPAdd:PublicIpAddress,PrivateIPAdd:PrivateIpAddress,InstanceName:Tags[?Key=='Name']|[0].Value,Status:State.Name}" --filters Name=instance-state-name,Values=running --output table

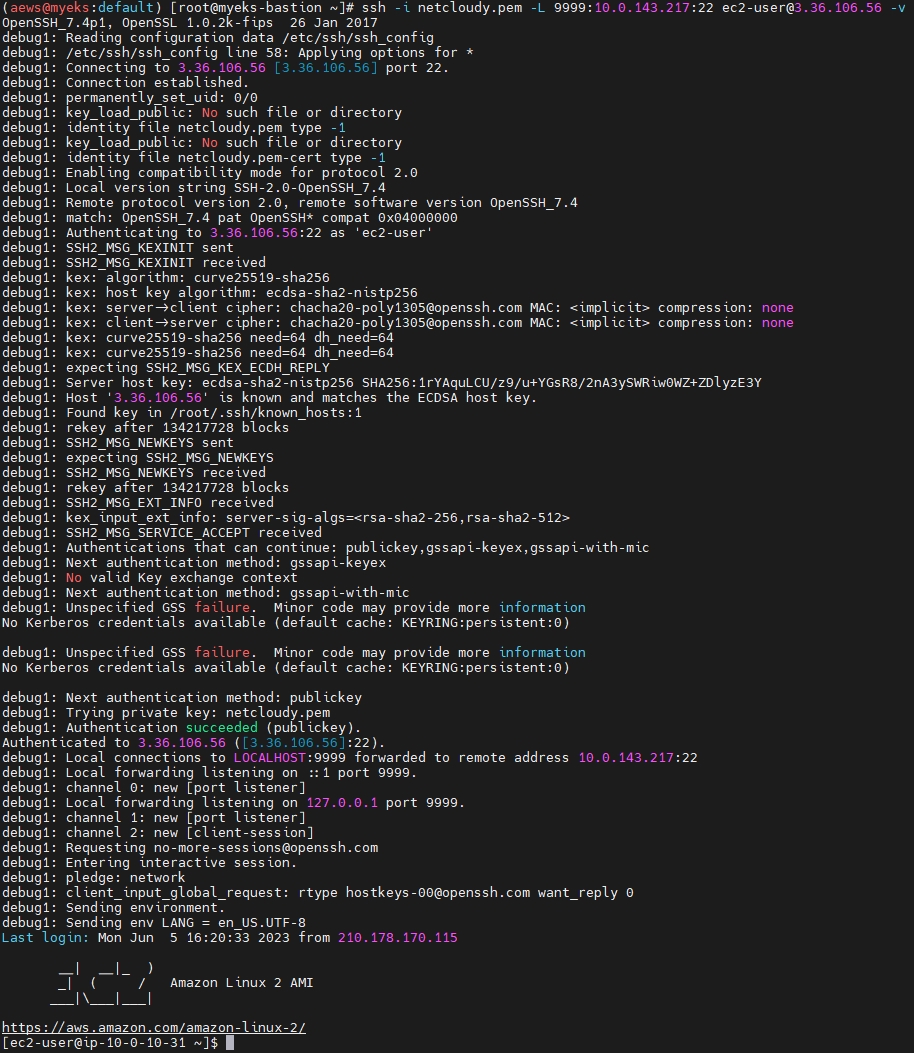

public 서브넷에 인스턴스에 SSH 터널링 설정

ssh -i <자신의 키페어파일> -L <자신의 임의 로컬 포트>:<private 서브넷의 인스턴스의 private ip 주소>:22 ec2-user@<public 서브넷에 인스턴스 퍼블릭IP> -v

ssh -i ~/.ssh/kp-gasida.pem -L 9999:10.0.129.196:22 ec2-user@3.34.96.12 -v

---

접속 후 그냥 두기

---

자신의 임의 로컬 포트로 SSH 접속 시, private 서브넷에 인스턴스 접속됨

ssh -i <자신의 키페어파일> -p <자신의 임의 로컬 포트> ec2-user@localhost

ssh -i ~/.ssh/kp-gasida.pem -p 9999 ec2-user@localhost

---

# IP 및 네트워크 정보 확인

ip -c addr

sudo ss -tnp

ping -c 2 8.8.8.8

curl ipinfo.io/ip ; echo # 출력되는 공인IP는 무엇인가?

exit

---

(이것도 역시 3.36.106.56로 확인)

실습 후 리소스 삭제

kubectl delete -f tutorial-bastion-host.yaml && kubectl delete -f tutorial-instance-private.yaml

kubectl delete -f vpc-workflow.yaml # vpc 관련 모든 리소스들 삭제에는 다소 시간이 소요됨

RDS

지원 엔진 - Aurora(MySQL & PostgreSQL), RDS for PostgreSQL, RDS for MySQL, RDS for MariaDB, RDS for Oracle, RDS for SQL Server

ACK RDS Controller 설치 with Helm - 링크 Public-Repo Github

# 서비스명 변수 지정 및 helm 차트 다운로드

export SERVICE=rds

export RELEASE_VERSION=$(curl -sL https://api.github.com/repos/aws-controllers-k8s/$SERVICE-controller/releases/latest | grep '"tag_name":' | cut -d'"' -f4 | cut -c 2-)

helm pull oci://public.ecr.aws/aws-controllers-k8s/$SERVICE-chart --version=$RELEASE_VERSION

tar xzvf $SERVICE-chart-$RELEASE_VERSION.tgz

# helm chart 확인

tree ~/$SERVICE-chart

# ACK EC2-Controller 설치

export ACK_SYSTEM_NAMESPACE=ack-system

export AWS_REGION=ap-northeast-2

helm install -n $ACK_SYSTEM_NAMESPACE ack-$SERVICE-controller --set aws.region="$AWS_REGION" ~/$SERVICE-chart

# 설치 확인

helm list --namespace $ACK_SYSTEM_NAMESPACE

kubectl -n $ACK_SYSTEM_NAMESPACE get pods -l "app.kubernetes.io/instance=ack-$SERVICE-controller"

kubectl get crd | grep $SERVICE

IRSA 설정 : 권장 정책 AmazonRDSFullAccess - ARN

# Create an iamserviceaccount - AWS IAM role bound to a Kubernetes service account

eksctl create iamserviceaccount \

--name ack-$SERVICE-controller \

--namespace $ACK_SYSTEM_NAMESPACE \

--cluster $CLUSTER_NAME \

--attach-policy-arn $(aws iam list-policies --query 'Policies[?PolicyName==`AmazonRDSFullAccess`].Arn' --output text) \

--override-existing-serviceaccounts --approve

# 확인 >> 웹 관리 콘솔에서 CloudFormation Stack >> IAM Role 확인

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

# Inspecting the newly created Kubernetes Service Account, we can see the role we want it to assume in our pod.

kubectl get sa -n $ACK_SYSTEM_NAMESPACE

kubectl describe sa ack-$SERVICE-controller -n $ACK_SYSTEM_NAMESPACE

# Restart ACK service controller deployment using the following commands.

kubectl -n $ACK_SYSTEM_NAMESPACE rollout restart deploy ack-$SERVICE-controller-$SERVICE-chart

# IRSA 적용으로 Env, Volume 추가 확인

kubectl describe pod -n $ACK_SYSTEM_NAMESPACE -l k8s-app=$SERVICE-chart

...

AWS RDS for MariaDB 생성 및 삭제 - 링크

# DB 암호를 위한 secret 생성

RDS_INSTANCE_NAME="<your instance name>"

RDS_INSTANCE_PASSWORD="<your instance password>"

RDS_INSTANCE_NAME=myrds

RDS_INSTANCE_PASSWORD=qwe12345

kubectl create secret generic "${RDS_INSTANCE_NAME}-password" --from-literal=password="${RDS_INSTANCE_PASSWORD}"

# 확인

kubectl get secret $RDS_INSTANCE_NAME-password

# [터미널1] 모니터링

RDS_INSTANCE_NAME=myrds

watch -d "kubectl describe dbinstance "${RDS_INSTANCE_NAME}" | grep 'Db Instance Status'"

# RDS 배포 생성 : 15분 이내 시간 소요 >> 보안그룹, 서브넷 등 필요한 옵션들은 추가해서 설정해보자!

cat <<EOF > rds-mariadb.yaml

apiVersion: rds.services.k8s.aws/v1alpha1

kind: DBInstance

metadata:

name: "${RDS_INSTANCE_NAME}"

spec:

allocatedStorage: 20

dbInstanceClass: db.t4g.micro

dbInstanceIdentifier: "${RDS_INSTANCE_NAME}"

engine: mariadb

engineVersion: "10.6"

masterUsername: "admin"

masterUserPassword:

namespace: default

name: "${RDS_INSTANCE_NAME}-password"

key: password

EOF

kubectl apply -f rds-mariadb.yaml

# 생성 확인

kubectl get dbinstances ${RDS_INSTANCE_NAME}

kubectl describe dbinstance "${RDS_INSTANCE_NAME}"

aws rds describe-db-instances --db-instance-identifier $RDS_INSTANCE_NAME | jq

kubectl describe dbinstance "${RDS_INSTANCE_NAME}" | grep 'Db Instance Status'

Db Instance Status: creating

kubectl describe dbinstance "${RDS_INSTANCE_NAME}" | grep 'Db Instance Status'

Db Instance Status: backing-up

kubectl describe dbinstance "${RDS_INSTANCE_NAME}" | grep 'Db Instance Status'

Db Instance Status: available

# 생성 완료 대기 : for 지정 상태가 완료되면 정상 종료됨

kubectl wait dbinstances ${RDS_INSTANCE_NAME} --for=condition=ACK.ResourceSynced --timeout=15m

dbinstance.rds.services.k8s.aws/myrds condition met

이후 배포가 안되어 일단 보류...

MariaDB 접속 - 링크 FieldExport

fieldexport 생성 : 아래 코드 블록 복붙!

RDS_INSTANCE_CONN_CM="${RDS_INSTANCE_NAME}-conn-cm"

cat <<EOF > rds-field-exports.yaml

---

apiVersion: v1

kind: ConfigMap

metadata:

name: ${RDS_INSTANCE_CONN_CM}

data: {}

---

apiVersion: services.k8s.aws/v1alpha1

kind: FieldExport

metadata:

name: ${RDS_INSTANCE_NAME}-host

spec:

to:

name: ${RDS_INSTANCE_CONN_CM}

kind: configmap

from:

path: ".status.endpoint.address"

resource:

group: rds.services.k8s.aws

kind: DBInstance

name: ${RDS_INSTANCE_NAME}

---

apiVersion: services.k8s.aws/v1alpha1

kind: FieldExport

metadata:

name: ${RDS_INSTANCE_NAME}-port

spec:

to:

name: ${RDS_INSTANCE_CONN_CM}

kind: configmap

from:

path: ".status.endpoint.port"

resource:

group: rds.services.k8s.aws

kind: DBInstance

name: ${RDS_INSTANCE_NAME}

---

apiVersion: services.k8s.aws/v1alpha1

kind: FieldExport

metadata:

name: ${RDS_INSTANCE_NAME}-user

spec:

to:

name: ${RDS_INSTANCE_CONN_CM}

kind: configmap

from:

path: ".spec.masterUsername"

resource:

group: rds.services.k8s.aws

kind: DBInstance

name: ${RDS_INSTANCE_NAME}

EOF

kubectl apply -f rds-field-exports.yaml확인

# 상태 정보 확인 : address 와 port 정보

kubectl get dbinstances myrds -o jsonpath={.status.endpoint} | jq

{

"address": "myrds.cb79jlim4dyq.ap-northeast-2.rds.amazonaws.com",

"hostedZoneID": "ZLA2NUCOLGUUR",

"port": 3306

}

# 상태 정보 확인 : masterUsername 확인

kubectl get dbinstances myrds -o jsonpath={.spec.masterUsername} ; echo

# 컨피그맵 확인

kubectl get cm myrds-conn-cm -o yaml | kubectl neat | yh

apiVersion: v1

data:

default.myrds-host: myrds.cb79jlim4dyq.ap-northeast-2.rds.amazonaws.com

default.myrds-port: "3306"

default.myrds-user: admin

kind: ConfigMap

metadata:

name: myrds-conn-cm

namespace: default

# fieldexport 정보 확인

kubectl get crd | grep fieldexport

kubectl get fieldexport

kubectl get fieldexport myrds-host -o yaml | k neat | yh- RDS 사용하는 파드를 생성RDS 의 master 암호를 변경해보고 확인!

# [터미널]

watch -d "kubectl get dbinstance; echo; kubectl get cm myrds-conn-cm -o yaml | kubectl neat"

# 아래 처럼 RDS 에서 직접 변경 할 경우 rds controller 를 별도 추적을 하지 않아서, k8s 상태와 aws 상태 정보가 깨져버럼

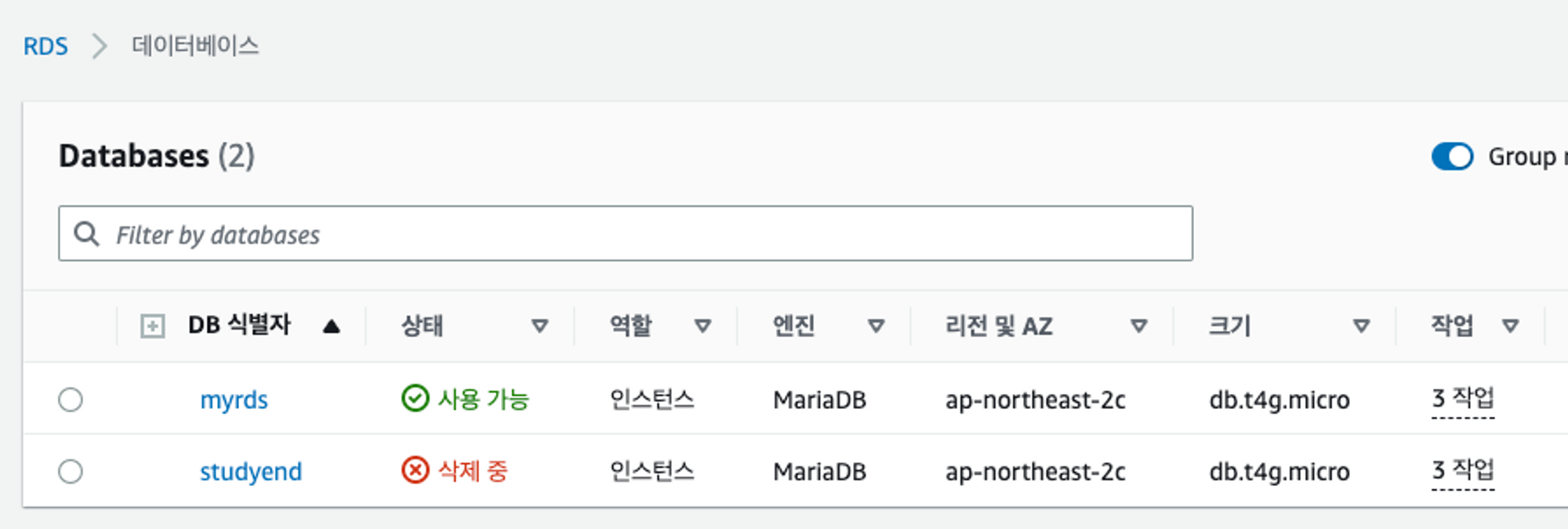

# DB 식별자 변경 : studyend

aws rds modify-db-instance --db-instance-identifier $RDS_INSTANCE_NAME --new-db-instance-identifier studyend --apply-immediately

# DB 식별자를 업데이트 >> 어떤 현상이 발생하는가?

kubectl patch dbinstance myrds --type=merge -p '{"spec":{"dbInstanceIdentifier":"studyend"}}'

# 확인

kubectl get dbinstance myrds

kubectl describe dbinstance myrds

- 최종적으로 변경된 status 정보가 반영되었는지 확인해보자

# 상태 정보 확인 : address 변경 확인!

kubectl get dbinstances myrds -o jsonpath={.status.endpoint} | jq

{

"address": "studyend.cb79jlim4dyq.ap-northeast-2.rds.amazonaws.com",

"hostedZoneID": "ZLA2NUCOLGUUR",

"port": 3306

}

# 파드의 환경 변수 확인 >> 파드의 경우 환경 변수 env로 정보를 주입했기 때문에 변경된 정보를 확인 할 수 없다

kubectl exec -it app -- env | grep DB

DBHOST=myrds.cb79jlim4dyq.ap-northeast-2.rds.amazonaws.com

DBPORT=3306

DBUSER=admin

DBPASSWORD=qwe12345

# 파드 삭제 후 재생성 후 확인

kubectl delete pod app && kubectl apply -f rds-pods.yaml

# 파드의 환경 변수 확인 >> 변경 정보 확인!

# 즉 deployments, daemonsets, statefulsets 의 경우 rollout 으로 env 변경 적용을 할 수 는 있겠다!

kubectl exec -it app -- env | grep DB

DBHOST=studyend.cb79jlim4dyq.ap-northeast-2.rds.amazonaws.com

DBPORT=3306

DBUSER=admin

DBPASSWORD=qwe12345

RDS 삭제 > AWS 웹 관리콘솔에서 myrds 는 직접 삭제 할 것

# 파드 삭제

kubectl delete pod app

# RDS 삭제

kubectl delete -f rds-mariadb.yaml

결론

쿠버네티스에서 AWS의 여러 서비스들을 생성하고 관리할 수 있게 기능을 제공한다니... 진정한 클라우드 네이티브화가 다가오고 있음이 느껴진다.

아직은 전부 GA가 된 건 아니지만, 프로젝트에서 써보는 것을 고려할 정도로 괜찮은 기능으로 보인다.

새로운 리소스를 terraform으로 배포할 것이냐 ACK 배포할 것이냐를 고민.

- terraform : 소스코드 기반으로 CI/CD 파이프라인 수행 가능

- ACK : 명령어 기반이지만, yaml로 준비해두고 젠킨스와 같은 CI 툴로도 배포 가능

이걸 좀 큰 규모에서 다룬다고 한다면 전사의 클라우드 리소스를 요청자가 티켓 형태로 open하고 수동 or 자동으로 리소스를 배포하는 형태가 있을 것이다.

클라우드 리소스를 생성하고 관리하는 툴로는 사실 비슷한 서비스들이 몇몇 있는 것이 현실이다. 클라우드 리소스 프로비저닝 툴인 ServiceNow나 CloudBolt 등등이 그 예일 것이다.

앞단에서는 UI 형태로 입력을 받고, 승인 절차를 거치면 미리 준비된 terraform Template으로 리소스를 생성하는 과정을 거친다.(수동일수도 있고...)

ACK가 조금 더 발전된다면, 위에 나열한 서비스의 back단을 ACK가 대체하여 현재 리소스 확인이나 생성, 관리 등을 할 수 있을 것이다.

'Tech > Kubernetes' 카테고리의 다른 글

| [AEWS_1기] 7주차 - EKS Automation (2/2) - Flux (0) | 2023.06.06 |

|---|---|

| [AEWS_1기] 6주차 - EKS Security (2/3) - EKS 인증/인가 (0) | 2023.05.31 |

| [AEWS_1기] 6주차 - EKS Security (1/3) - K8S 인증/인가 (0) | 2023.05.31 |

| [AEWS_1기] 5주차 - EKS Autoscaling (3/6) - VPA (0) | 2023.05.22 |

| [AEWS_1기] 5주차 - EKS Autoscaling (2/6) - KEDA (0) | 2023.05.22 |

댓글