본 시리즈는 가시다님의 AEWS(AWS EKS Workshop) 1기 진행 내용입니다. (가시다님 노션)

스터디에 사용되는 링크 (AWS EKS Workshop)

목차

1. 스토리지의 이해 (링크)

2. AWS EBS Controller (링크)

3. AWS Volume Snapshots Controller (링크)

4. AWS EFS Controller

5. AWS Persistent Volume for Instance Store & Add Node Group

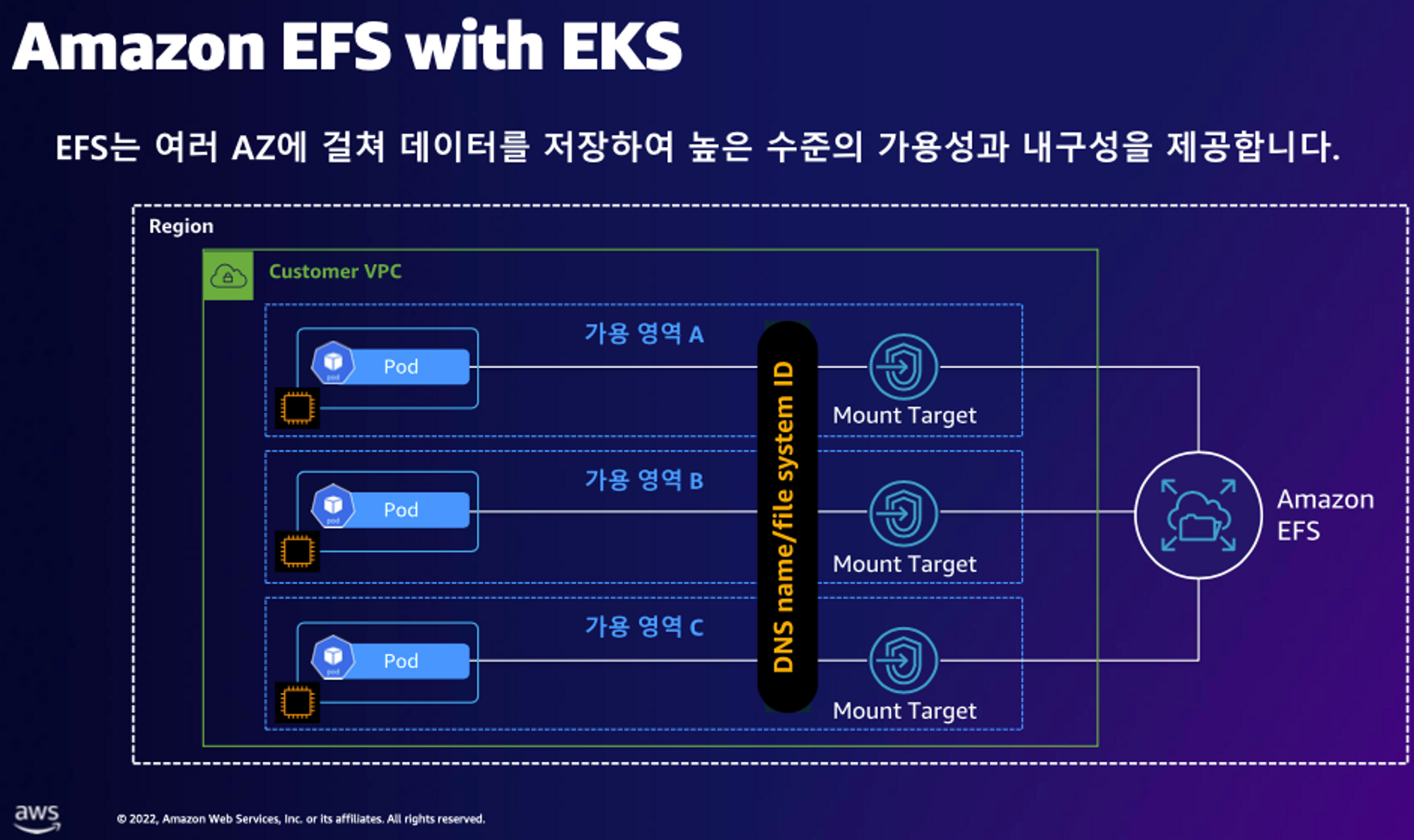

4. AWS EFS Controller

EFS 파일시스템 확인 및 EFS Controller 설치

# EFS 정보 확인

aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text

# IAM 정책 생성

curl -s -O https://raw.githubusercontent.com/kubernetes-sigs/aws-efs-csi-driver/master/docs/iam-policy-example.json

aws iam create-policy --policy-name AmazonEKS_EFS_CSI_Driver_Policy --policy-document file://iam-policy-example.json

# ISRA 설정 : 고객관리형 정책 AmazonEKS_EFS_CSI_Driver_Policy 사용

eksctl create iamserviceaccount \

--name efs-csi-controller-sa \

--namespace kube-system \

--cluster ${CLUSTER_NAME} \

--attach-policy-arn arn:aws:iam::${ACCOUNT_ID}:policy/AmazonEKS_EFS_CSI_Driver_Policy \

--approve

# ISRA 확인

kubectl get sa -n kube-system efs-csi-controller-sa -o yaml | head -5

eksctl get iamserviceaccount --cluster myeks

# EFS Controller 설치

helm repo add aws-efs-csi-driver https://kubernetes-sigs.github.io/aws-efs-csi-driver/

helm repo update

helm upgrade -i aws-efs-csi-driver aws-efs-csi-driver/aws-efs-csi-driver \

--namespace kube-system \

--set image.repository=602401143452.dkr.ecr.${AWS_DEFAULT_REGION}.amazonaws.com/eks/aws-efs-csi-driver \

--set controller.serviceAccount.create=false \

--set controller.serviceAccount.name=efs-csi-controller-sa

# 확인

helm list -n kube-system

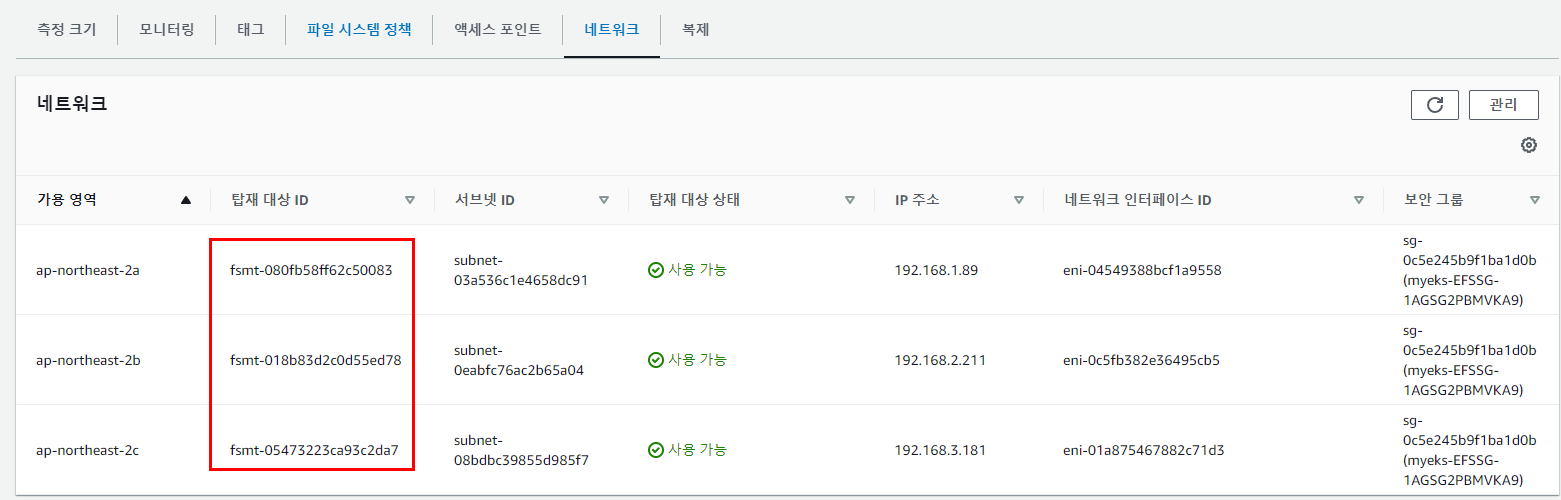

kubectl get pod -n kube-system -l "app.kubernetes.io/name=aws-efs-csi-driver,app.kubernetes.io/instance=aws-efs-csi-driver"- AWS → EFS → 파일 시스템 : 네트워크 → 탑재 대상 ID 확인

EFS 파일시스템을 다수의 파드가 사용하게 설정 : Add empty StorageClasses from static example

# 모니터링

watch 'kubectl get sc efs-sc; echo; kubectl get pv,pvc,pod'

# 실습 코드 clone

git clone https://github.com/kubernetes-sigs/aws-efs-csi-driver.git /root/efs-csi

cd /root/efs-csi/examples/kubernetes/multiple_pods/specs && tree

# EFS 스토리지클래스 생성 및 확인

cat storageclass.yaml | yh

kubectl apply -f storageclass.yaml

kubectl get sc efs-sc

# PV 생성 및 확인 : volumeHandle을 자신의 EFS 파일시스템ID로 변경

EfsFsId=$(aws efs describe-file-systems --query "FileSystems[*].FileSystemId" --output text)

sed -i "s/fs-4af69aab/$EfsFsId/g" pv.yaml

cat pv.yaml | yh

apiVersion: v1

kind: PersistentVolume

metadata:

name: efs-pv

spec:

capacity:

storage: 5Gi

volumeMode: Filesystem

accessModes:

- ReadWriteMany

persistentVolumeReclaimPolicy: Retain

storageClassName: efs-sc

csi:

driver: efs.csi.aws.com

volumeHandle: fs-05699d3c12ef609e2

kubectl apply -f pv.yaml

kubectl get pv; kubectl describe pv

# PVC 생성 및 확인

cat claim.yaml | yh

kubectl apply -f claim.yaml

kubectl get pvc

# 파드 생성 및 연동 : 파드 내에 /data 데이터는 EFS를 사용

cat pod1.yaml pod2.yaml | yh

kubectl apply -f pod1.yaml,pod2.yaml

kubectl df-pv

# 파드 정보 확인 : PV에 5Gi 와 파드 내에서 확인한 NFS4 볼륨 크리 8.0E의 차이는 무엇? 파드에 6Gi 이상 저장 가능한가?

kubectl get pods

kubectl exec -ti app1 -- sh -c "df -hT -t nfs4"

kubectl exec -ti app2 -- sh -c "df -hT -t nfs4"

Filesystem Type Size Used Available Use% Mounted on

127.0.0.1:/ nfs4 8.0E 0 8.0E 0% /data

# 공유 저장소 저장 동작 확인

tree /mnt/myefs # 작업용EC2에서 확인

tail -f /mnt/myefs/out1.txt # 작업용EC2에서 확인

kubectl exec -ti app1 -- tail -f /data/out1.txt

kubectl exec -ti app2 -- tail -f /data/out2.txt- 실습 완료 후 삭제

# 쿠버네티스 리소스 삭제

kubectl delete pod app1 app2

kubectl delete pvc efs-claim && kubectl delete pv efs-pv && kubectl delete sc efs-sc

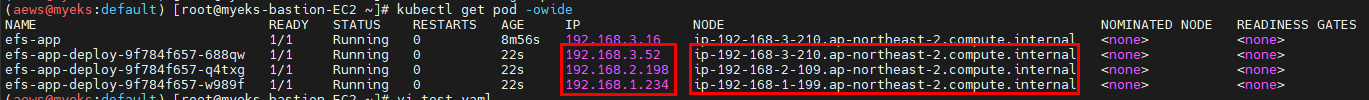

자 그럼 정말로 여러 AZ간에 pod가 잘 배포되는지 확인해보자

## test-deploy.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: efs-app-deploy

labels:

app: efs

spec:

replicas: 3

selector:

matchLabels:

app: efs

template:

metadata:

labels:

app: efs

spec:

containers:

- name: app1

image: busybox

command: ["/bin/sh"]

args: ["-c", "while true; do echo $(date -u) >> /data/out1.txt; sleep 5; done"]

volumeMounts:

- name: persistent-storage

mountPath: /data

volumes:

- name: persistent-storage

persistentVolumeClaim:

claimName: efs-claim

## kubectl apply -f test-deploy.yaml

잘 배포되는 것 확인!

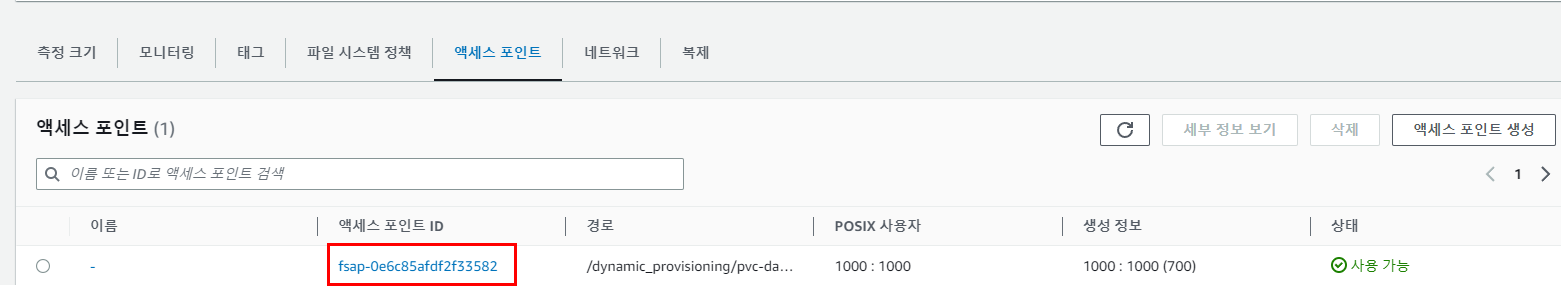

EFS 파일시스템을 다수의 파드가 사용하게 설정 : Dynamic provisioning using EFS

# 모니터링

watch 'kubectl get sc efs-sc; echo; kubectl get pv,pvc,pod'

# EFS 스토리지클래스 생성 및 확인

curl -s -O https://raw.githubusercontent.com/kubernetes-sigs/aws-efs-csi-driver/master/examples/kubernetes/dynamic_provisioning/specs/storageclass.yaml

cat storageclass.yaml | yh

sed -i "s/fs-92107410/$EfsFsId/g" storageclass.yaml

kubectl apply -f storageclass.yaml

kubectl get sc efs-sc

# PVC/파드 생성 및 확인

curl -s -O https://raw.githubusercontent.com/kubernetes-sigs/aws-efs-csi-driver/master/examples/kubernetes/dynamic_provisioning/specs/pod.yaml

cat pod.yaml | yh

kubectl apply -f pod.yaml

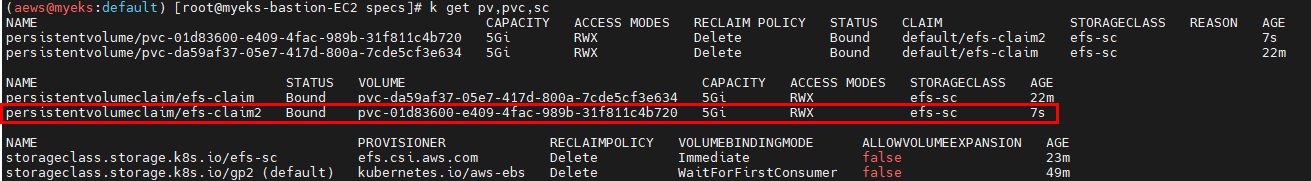

kubectl get pvc,pv,pod

# PVC/PV 생성 로그 확인

kubectl logs -n kube-system -l app=efs-csi-controller -c csi-provisioner -f

# 파드 정보 확인

kubectl exec -it efs-app -- sh -c "df -hT -t nfs4"

Filesystem Type Size Used Available Use% Mounted on

127.0.0.1:/ nfs4 8.0E 0 8.0E 0% /data

# 공유 저장소 저장 동작 확인

tree /mnt/myefs # 작업용EC2에서 확인

kubectl exec efs-app -- bash -c "cat data/out"- EFS → 액세스 포인트 확인

- 실습 완료 후 삭제

# 쿠버네티스 리소스 삭제

kubectl delete -f pod.yaml

kubectl delete -f storageclass.yaml

Static과 Dynamic의 차이

dynamic은 base_path 하위에 pvc명이 디렉토리로 잡히게 된다.

EFS SC를 사용하는 PVC를 추가하면 더 생긴다

pod에 volume을 mount하여 파일을 쓰면 아래와 같이 사용 중인 것도 확인 가능하다.

결론

EBS와는 다르게 공유 스토리지로 사용되는 파일 스토리지인 EFS에 대해서 알아보았다.

간단히 정리하면 아래와 같다.

- EFS 장점

- 다중 AZ 및 리전 확장 : EFS는 여러 AZ 및 리전에서 확장 가능하며, 고가용성과 높은 확장성

- 공유 파일 시스템 : 여러 인스턴스에서 동시에 액세스할 수 있는 공유 파일 시스템 제공

- POSIX 호환 : EFS는 POSIX 호환 파일 시스템으로, 기존 애플리케이션에 쉽게 통합

- EFS 단점

- 비용 : EFS는 비교적 높은 가격 대비 저장 용량 비용

- 레이턴시 : EFS는 높은 레이턴시를 가질 수 있어 I/O 지연이 중요한 애플리케이션에는 적합하지 않음

앞서 학습한 EBS는 단일 AZ에 의존하는 단일 인스턴스 환경 및 I/O 집약적인 워크로드에 적합하며, EFS는 다중 AZ 및 다중 인스턴스에서 공유 파일 시스템을 필요로 하는 환경에 적합하다.

댓글